LlamaCloud

LlamaParse é uma API criada pelo LlamaIndex para analisar e representar ficheiros de forma eficiente para uma recuperação eficiente e aumento de contexto utilizando as estruturas do LlamaIndex. LlamaParse pode suportar diferentes tipos de ficheiros, como pdf, doc, .ppt, e outros formatos.

Pode configurar o LlamaParse para utilizar o nó Gaia como backend LLM, pelo que pode criar localmente uma aplicação RAG baseada nos seus ficheiros PDF.

Pré-requisitos

É necessário um nó Gaia preparado para fornecer serviços LLM através de um URL público. Pode

Neste tutorial, utilizaremos nós públicos para alimentar o plug-in Continue.

| Tipo de modelo | URL de base da API | Nome do modelo |

|---|---|---|

| Conversa | https://llama8b.gaia.domains/v1 | lhama |

| Incorporação | https://llama8b.gaia.domains/v1 | nómico-embutido |

Passos

Utilizaremos um repositório GitHub de código aberto, chamado llamaparse-integraçãopara tornar o LlamaPase fácil de utilizar. O llamaparse-integração suportes de aplicação

- Vários formatos de ficheiro, como

.pdfe.doc, - Vários ficheiros

Primeiro, precisamos de ter o código fonte no seu terminal.

git clone https://github.com/alabulei1/llamaparse-integration.git

cd llamaparse-integration

Em seguida, instale os pacotes de modo necessários.

npm install llamaindex

npm install dotenv

Iniciar uma instância Qdrant. A instância Qdrant destina-se a armazenar os embeddings.

mkdir qdrant_storage

mkdir qdrant_snapshots

nohup docker run -d -p 6333:6333 -p 6334:6334 \

-v $(pwd)/qdrant_storage:/qdrant/storage:z \

-v $(pwd)/qdrant_snapshots:/qdrant/snapshots:z \

qdrant/qdrant

Em seguida, será necessário configurar as definições do modelo LLM. Podemos configurar a definição do modelo na secção .env ficheiro.

OPENAI_BASE_URL=https://llama8b.gaia.domains/v1/

OPENAI_API_KEY=gaianet

LLAMAEDGE_CHAT_MODEL=llama

LLAMAEDGE_EMBEDDING_MODEL=nomic

LLAMA_CLOUD_API_KEY=Sua_própria_KEY

FILE_PATH=

FILE_DIR=./pdf_dir

COLLECTION_NAME=default

QDRANT_URL=http://127.0.0.1:6333

SAVE_MARKDOWN_PATH=output.md

Eis algumas notas sobre o .env configuração:

- Pode obter a chave LlamaCloud em https://cloud.llamaindex.ai

- Poderá ser necessário efetuar alterações de acordo com a definição do modelo e o caminho do ficheiro.

- Se colocar o nome do ficheiro no campo

FILE_PATH=o programa criará uma aplicação RAG com este único ficheiro pdf. - Se o

FILE_PATH=estiver vazio, o programa irá construir uma aplicação RAG com os ficheiros sob oFILE_DIR=./pdf_dir. É possível incluir vários ficheiros na pasta.

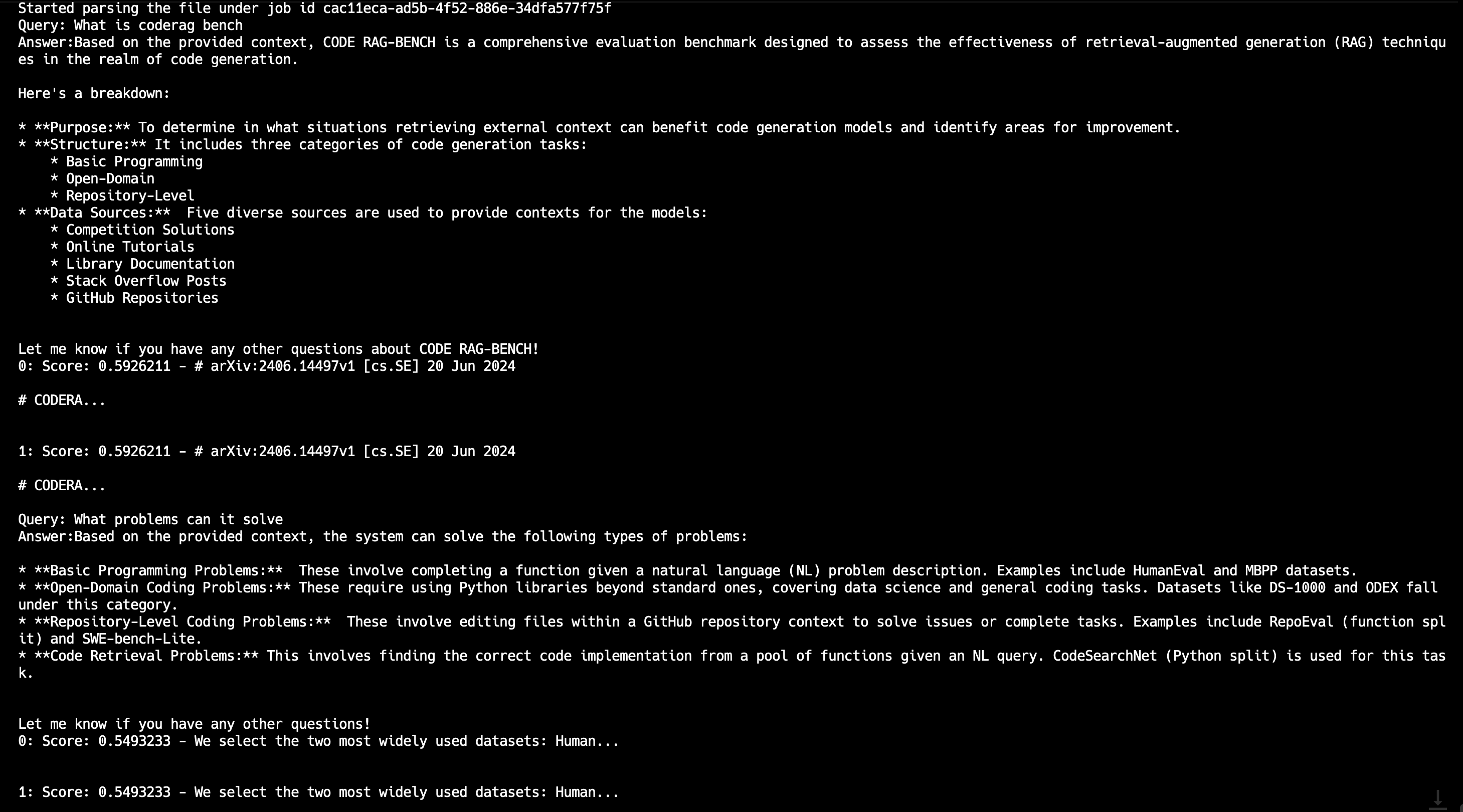

Em seguida, podemos executar o programa para criar uma aplicação RAG com base no ficheiro PDF

npx tsx pdfRender.ts

Depois de ser executado com êxito, pode enviar uma consulta através da linha de comandos.